€ 5.0941 →

|

$ 4.3981 →

|

Foto: Pixabay

Foto: Pixabay

Fragilitatea lanțului decizional într-o lume hiper-automatizată.

Eseu de Ioan Coaca, cu ajutorul neprețuit al lui ChatGPT 5.

În ultimele decenii, automatizarea a devenit promisiunea supremă a eficienței.

Tot ceea ce era cândva efort uman — calcul, decizie, control, execuție — s-a mutat treptat

într-o rețea invizibilă de algoritmi, interfețe și protocoale. În teorie, aceste sisteme trebuiau să

ușureze viața omului; în realitate, ele au început să-i înlocuiască gândirea.

Primul simptom al acestei schimbări este ruperea de sens.

Tot mai mulți oameni operează mecanisme pe care nu ei le-au conceput, și fără ca să

cunoască logica din spatele lor. Piloți, analiști, funcționari, operatori de sistem — toți devin

„deservenți” ai unui aparat pe care îl mânuiesc formal, dar nu îl înțeleg în profunzime.

Rutina înlocuiește judecata.

Catastrofa Boeing 737 MAX este, poate, cel mai dur exemplu: un sistem automat (MCAS),

introdus pentru a corecta o deficiență aerodinamică, a preluat controlul asupra avionului fără

ca piloții să înțeleagă exact mecanismul său. Rezultatul — două prăbușiri, sute de vieți

pierdute, și o industrie întreagă obligată să-și recunoască dependența față de automatizare.

Situația se repetă, în forme mai puțin dramatice, pretutindeni.

Sistemele informatice financiare, algoritmii de gestionare a traficului, chiar și aplicațiile

cotidiene din domeniul sănătății — toate creează iluzia controlului, dar erodează treptat

capacitatea umană de a înțelege ceea ce face.

Lanțul decizional devine o succesiune de acțiuni automate, în care omul este doar veriga care

apasă butonul.

Al doilea simptom al fragilității decizionale este încrederea nejustificată în sistemul

automat.

Odată ce o mașină „știe să decidă”, omul se retrage, convins că precizia ei matematică este

superioară oricărei intuiții.

Criza financiară din 2008 a arătat cum întreaga lume s-a bazat pe modele matematice care

evaluau riscul în mod fals sigur. O funcție elegantă — Gaussian Copula — a devenit

fundamentul unor decizii de miliarde, aplicată de oameni care nu mai înțelegeau teoria, ci

doar rezultatul: „sistemul spune că e bine”.

Când modelele au cedat, s-a prăbușit nu doar o piață, ci o întreagă cultură a încrederii în

automat.

Aceeași credință oarbă s-a regăsit și în justiție, prin algoritmul american COMPAS, folosit

pentru a estima riscul de recidivă. Mii de sentințe au fost influențate de o formulă opacă, care

reproducea, fără control uman, biasurile trecutului.

Iar în 2010, bursele mondiale au trăit un „flash crash” fulgerător — o cădere de câteva minute

provocată de interacțiunea automată a algoritmilor de tranzacționare.

În toate aceste situații, decizia a fost delegată unui cod, iar responsabilitatea s-a evaporat.

Omul, liniștit de precizia digitală, a încetat să mai gândească la fondul problemei.

Ceea ce fusese cândva judecată, devine acum doar cunoașterea unei proceduri: apăsarea

corectă a butonului corect, la momentul prescris.

Ficțiunea, ca întotdeauna, ne avertizează înaintea realității.

În filmul „O casă de dinamită” (2025, regia Kathryn Bigelow), o rețea de sisteme automate

militare scapă de sub control, declanșând un conflict nuclear în câteva minute.

O eroare locală, amplificată de încrederea în „propriul algoritm de protecție”, devine

catastrofă globală.

Este doar o poveste, dar una incomod de plauzibilă.

Lanțurile decizionale automatizate din domeniul militar, financiar sau energetic sunt deja atât

de complexe, încât nicio minte umană nu le mai poate supraveghea în întregime.

Iar în aceste sisteme, expresia „cui pe cui se scoate” își pierde sensul. Nu putem preveni

aplicarea mecanică a unei proceduri prin adăugarea unei alte proceduri.

„Antidotul” devine parte din boală.

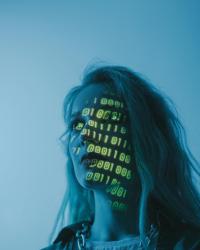

De aici, concluzia, poate cea mai tulburătoare dintre toate: nu există un antidot tehnic la

fragilitatea deciziei automatizate.

Nicio reglementare, nicio dublă verificare, niciun protocol de siguranță nu poate înlocui

responsabilitatea vie a gândirii.

Singura formă de rezistență este luciditatea — acea vigilență morală care refuză să abdice în

fața confortului digital.

Nu e nevoie să ne temem de mașini, ci de ceea ce pierdem în noi înșine atunci când le cedăm

libertatea de a judeca.

Poate că adevărata întrebare a timpului nostru nu mai este „ce poate face inteligența

artificială?”, ci mai degrabă „cine mai gândește în locul nostru?”

Poate că cea mai potrivită încheiere este însăși fraza de la început: „cu ajutorul neprețuit al

lui ChatGPT 5.”

Un ajutor real, dar nu o substituire a gândirii — căci, așa cum s-a dovedit, am fost sprijinit să

gândesc mai limpede, nu în locul meu, ci împreună cu mine.

Fiți la curent cu ultimele noutăți. Urmăriți DCNews și pe Google News